FineVision Open Data Is All You Need

L. Wiedmann, O. Zohar, A. Mahla, X. Wang, R. Li, T. Frere, L. von Werra, A. R. Gosthipaty and A. Marafioti, "FineVision: Open Data Is All You Need", Preprint, 2025, DOI: 10.48550/arXiv.2510.17269.

Vision-Language Model(VLM)의 발전은 단편적이고 오염된 공개 데이터셋의 혼재된 환경으로 인해 방해받고 있습니다. 이 논문은 세심하게 수집, 큐레이션, 통합된 2,400만 샘플의 코퍼스인 FineVision을 소개합니다. 이는 동종 최대 규모의 오픈 리소스입니다.

요약

아키텍처: SmolVLM(460M 파라미터)을 사용하며, SmolLM2-360M-Instruct 텍스트 백본과 SigLIP2-Base-512 비전 인코더로 구성됩니다.

사용 데이터셋: 200개 이상의 소스를 185개의 서브셋으로 통합했습니다. 총 2,400만 샘플, 1,700만 이미지, 8,900만 턴, 95억 답변 토큰을 포함합니다.

평가 매트릭: lmms-eval 프레임워크를 사용하여 11개 벤치마크(AI2D, ChartQA, DocVQA, InfoVQA, MME, MMMU, ScienceQA, MMStar, OCRBench, TextVQA, SEED-Bench)에서 평가했습니다.

훈련 방법: 단일 단계 학습 프로토콜을 사용하며, 배치 크기 512로 20,000 스텝 동안 학습합니다(약 32 H100 GPU로 20시간). 시퀀스 패킹을 사용하여 최대 길이 8192로 설정하며, FineVision 데이터셋을 1 에폭 이상 커버합니다.

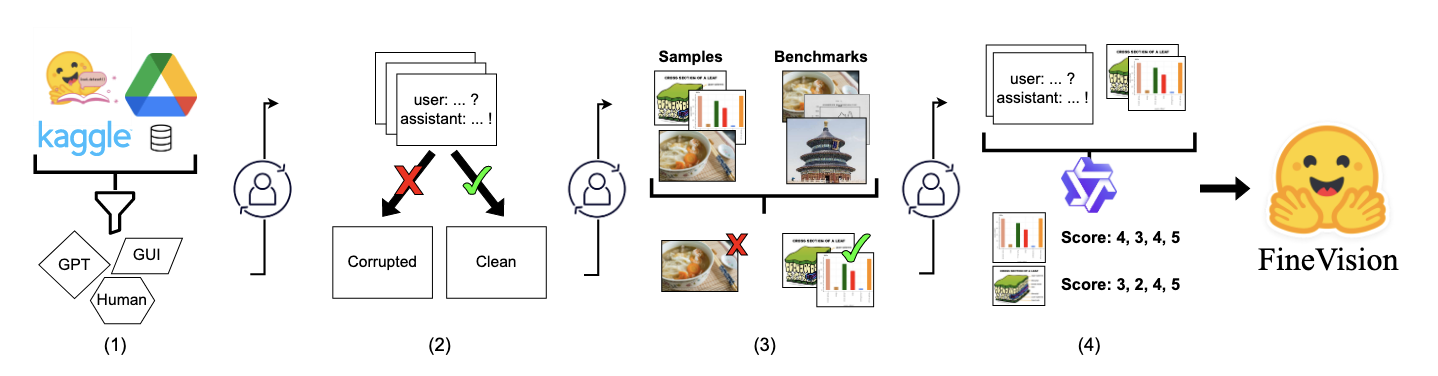

큐레이션 프로세스: (1) 원시 소스 수집, (2) 정규화 및 이미지/텍스트 정제, (3) SSCD 임베딩을 사용한 중복 제거 및 테스트 세트 오염 제거, (4) LLM/VLM-as-a-judge를 통한 턴별 품질 평가를 포함합니다.

주요 결과: FineVision으로 학습된 모델은 기존 오픈 데이터셋 대비 일관되게 우수한 성능을 보였습니다: The Cauldron 대비 40.7%, Cambrian-1 대비 12.1%, LLaVA-OneVision 대비 46.3% 상대적 개선을 11개 벤치마크 평균에서 달성했습니다.

논문 상세

Introduction

Vision-Language Model(VLM)의 놀라운 발전은 모델 용량과 학습 데이터의 확장에 의해 촉진되었습니다. 그러나 오픈 연구 커뮤니티는 중요한 병목 현상에 직면해 있습니다: 멀티모달 공개 데이터셋이 단편적이고 일관성이 없으며 종종 오염되어 있습니다. 독점 모델이 대규모의 큐레이션된 코퍼스로 학습되는 반면, 오픈 대안은 많은 소규모 전문 데이터셋을 연결해야 합니다.

초기 오픈 집계 노력은 The Cauldron, Cambrian-1, LLaVA-OneVision 같은 작업으로 시작되었습니다. 이러한 노력은 출시 당시 경쟁력이 있었으며 이질적인 소스를 통합하여 중요한 기반을 마련했습니다. 이후 선도적인 오픈소스 모델들은 수백 개의 데이터셋에 걸친 훨씬 더 큰 학습 혼합으로 전환했습니다. 예를 들어 Eagle2와 PerceptionLM은 각각 약 200개의 데이터셋을 사용한다고 보고합니다.

이 과제를 해결하기 위해, 2,400만 개 이상의 샘플, 1,700만 이미지, 8,900만 턴, 95억 답변 토큰으로 구성된 세심하게 설계된 코퍼스인 FineVision을 소개합니다. 우리의 주요 기여는 이 데이터셋의 수집, 엄격한 큐레이션 및 오픈 릴리스로, VLM 학습 및 평가를 위한 신뢰할 수 있고 즉시 사용 가능한 기반을 제공합니다.

FineVision Curation

FineVision은 오픈소스 VLM 커뮤니티에서 다양하고 고품질 학습 데이터에 대한 중요한 필요를 해결하기 위한 대규모 데이터 큐레이션 노력을 통해 만들어졌습니다. 우리는 반자동화된 human-in-the-loop 프로세스를 통해 200개 이상의 공개 데이터셋을 최종적으로 185개의 서브셋으로 통합했습니다.

Data Sources

데이터 수집 프로세스는 포괄적으로 설계되었으며, 원저자가 공개적으로 릴리스한 곳이라면 어디서나 데이터셋을 집계했습니다:

- 공개 데이터셋 허브: Hugging Face Datasets 같은 플랫폼

- 기관 및 클라우드 스토리지: Google Drive 등의 공개 공유 링크

- 코드 리포지토리: 연구 코드와 함께 공유되는 GitHub 리포지토리

- 직접 웹 다운로드: 프로젝트 웹사이트 및 기타 직접 다운로드 링크

필터링 및 중복 제거 후 185개의 서브셋으로 정리되었습니다.

From Heterogeneous Annotations to Unified Conversations

200개 이상의 공개 데이터셋을 instruction tuning에 적합한 통합 형식으로 변환하는 것은 상당한 엔지니어링 과제였습니다. 각 데이터셋은 자체 주석 스키마, 작업 공식화 및 데이터 구성을 가지고 있었습니다.

반자동화 변환 파이프라인: Claude를 에이전트로 사용하여 각 데이터셋 변환을 관리 가능한 하위 작업으로 분해했습니다: (1) 각 데이터셋의 구조와 의미를 이해하기 위한 심층 주석 분석, (2) 소스 주석을 대화 형식으로 매핑하는 전략 설계, (3) 광범위한 검증이 포함된 스크립트 구현, (4) 샘플링 및 수동 검사를 통한 품질 검증.

Human-in-the-loop 품질 관리: 각 데이터셋에 대해 검토자가 (i) 매핑 계획과 템플릿 선택을 평가하고, (ii) 컨버터의 드라이런을 검사하며, (iii) 출력의 무작위 샘플을 감사하여 완전한 주석 소비와 적절한 형식 및 다양성을 확인했습니다. 문제가 발생하면(예: 누락된 필드 또는 취약한 템플릿) 검토자가 집중적인 지침을 제공하고 영향을 받은 단계를 다시 실행했습니다.

통합 대화 스키마: 모든 데이터셋은 표준화된 샘플 수준 표현으로 수렴됩니다:

\[\text{sample} = {\text{images}, \text{texts}, \text{source}, \text{metadata}}\]

여기서 texts는 사용자와 어시스턴트 역할 사이를 번갈아 가는 대화 턴 목록을 포함합니다. 비대화형 소스(예: 분류 데이터셋)는 신중하게 설계된 템플릿을 사용하여 자연스러운 QA 쌍으로 변환됩니다.

작업별 변환 전략: 6가지 핵심 전략을 개발했습니다:

- Visual QA: 동일한 이미지에 대한 질문을 다중 턴 대화로 그룹화

- Captioning & Description: 원래 설명을 변경하지 않고 무작위 지시 프롬프트로 래핑

- Grounding & Spatial Relations: 공간 주석을 설명이 포함된 yes/no 질문으로 변환

- Document Understanding: 다중 페이지 문서를 이미지 리스트로 처리하고 질문을 대화로 연결

- OCR & Transcription: 정확한 전사 턴과 선택적 "이해" 턴 생성

- Classification & Detection: 보조 설명이 있을 때 설명이 포함된 결정 질문으로 변환

GUI 데이터를 위한 액션 공간 통합: 에이전트 비전 작업에서 새로운 기능을 활성화하기 위해 여러 GUI 자동화 데이터셋을 포함했습니다. 주요 과제는 액션 공간의 표준화 부족입니다. 이를 해결하기 위해 (i) 임의의 함수 서명을 추출하고 정규화하는 파서와 (ii) 모든 액션 표현을 통합 스키마로 매핑하는 액션 변환 모듈을 포함하는 데이터 변환 파이프라인을 구축했습니다.

Cleaning

대규모 데이터 집계에서 흔한 엣지 케이스를 처리하기 위해 여러 자동화된 정제 및 검증 단계를 포함했습니다.

이미지: 자동 이미지 검증을 수행하여 디코딩 불가능하거나 손상되었거나 0바이트인 이미지를 제거합니다. EXIF 메타데이터를 통해 이미지 방향을 조정하고 모든 형식을 RGB로 변환합니다. 가장 긴 변이 2048px를 초과하는 이미지는 종횡비를 유지하면서 크기를 조정합니다.

텍스트: UTF-8 인코딩 적용, 제어 문자 제거, 구두점과 따옴표 표준화, base64 블롭 같은 아티팩트 제거를 통해 텍스트 콘텐츠를 정규화합니다. 반복 토큰을 축소하고(예: !!!! → !) 빈 답변이나 퇴화된 답변이 있는 턴을 제거합니다. 학습 안정성을 보장하기 위해 모든 턴을 질문과 답변의 결합 길이 8192 토큰으로 제한합니다.

Near-Duplicate and Contamination Control

SSCD(self-supervised copy-detection descriptors)와 코사인 유사도를 사용하여 두 단계로 위생 처리를 수행합니다:

데이터셋 내부: FineVision 내에서 시각적으로 거의 동일한 이미지를 클러스터링하여 동일한 이미지의 샘플을 다중 턴 대화 또는 병합된 서브셋으로 병합합니다.

테스트 세트 오염 제거: 66개 공개 VLM 벤치마크의 평가 이미지와 유사한 학습 이미지를 식별하여 학습-테스트 누출을 완화합니다.

모든 단계는 코사인 유사도에서 \(\tau = 0.95\) 임계값을 공유하며, 가양성을 줄이기 위해 보수적인 방향으로 오류를 범합니다.

공개 벤치마크에 대한 오염 측정: 동일한 SSCD+코사인 프로토콜에 따라 lmms-eval에 포함된 66개 테스트 세트의 모든 이미지를 임베딩하고 각 학습 이미지에 대한 최대 유사도를 계산합니다. \(\tau\) 이상의 유사도를 가진 이미지는 플래그가 지정되며, 학습에서 제거하는 영향을 연구했지만, 이것이 오염된 샘플의 명확한 지표가 아니므로 FineVision을 원래 형태로 릴리스합니다.

Exploring FineVision

FineVision을 세 가지 주요 축을 따라 특성화합니다: 카테고리 구성, 턴 품질, 시각적 다양성.

Category Composition

모든 FineVision 서브셋을 9개의 구별되는 카테고리로 분류합니다: Captioning & Knowledge, Chart & Table, General VQA, Grounding & Counting, Mathematics, Naive OCR, OCR QA, Science, Text-only. 이미지 수, 샘플, 턴, 답변 토큰의 여러 축을 따라 결과 카테고리 구성을 분석합니다.

Chart & Table의 샘플은 일반적으로 다중 턴 대화에 적합합니다. 단일 차트에 대해 여러 유사한 질문을 할 수 있기 때문입니다. OCR QA의 샘플은 상세한 문서 이해를 목표로 하므로 답변이 더 긴 경향이 있습니다.

Analysis of Characteristic Axes

LLM/VLM-as-a-judge(텍스트 전용 기준의 경우 Qwen3-32B, 이미지 조건 기준의 경우 Qwen2.5VL-32B-Instruct)를 사용하여 네 가지 특성 축을 따라 1-5로 모든 학습 턴을 점수화합니다: Formatting, Relevance, Visual Dependency, Image-Question Correspondence.

Relevance는 카테고리 전반에 걸쳐 균일하게 높으며 턴의 85% 이상이 4 또는 5를 기록합니다. Formatting 점수는 전반적으로 높으며 턴의 97.2%가 4 또는 5를 기록하고 Grounding에서 최고치를 기록합니다.

비전 중심 축은 작업 특성을 가장 명확하게 구별합니다. Captioning과 General VQA는 Visual Dependency와 Formatting/Relevance 모두에서 높은 점수를 달성하는 반면 Image-Question Correspondence에서는 낮은 점수를 받습니다. Naive OCR도 Visual Dependency가 높지만 다른 축에서는 낮은 점수를 받습니다.

교차 축 패턴은 이러한 역할을 더욱 명확히 합니다. 두 가지 비전 축인 Visual Dependency와 Image-Question Correspondence는 역상관 관계에 있으며, 답변을 위해 이미지가 필요한 작업이 질문이 이미지 콘텐츠에 직접 대응하는 작업과 종종 다르다는 것을 나타냅니다.

Visual Diversity

SSCD 임베딩의 공분산 스펙트럼 통계를 사용하여 시각적 다양성을 분석합니다. \(\lambda_i\)를 임베딩 공분산의 고유값이라고 하면, 두 가지 상호 보완적인 측정값을 보고합니다:

Effective Rank: \(r_{eff} = \exp(H(p))\), 여기서 \(p_i = \lambda_i / \sum_j \lambda_j\)이고 \(H(p) = -\sum_i p_i \log p_i\). 더 높은 값은 분산이 더 많은 차원에 분산되어 더 큰 개념적 폭을 나타냅니다.

Participation Ratio: \(PR = (\sum_i \lambda_i)^2 / \sum_i \lambda_i^2\). 더 높은 값은 분산이 차원 전반에 더 균일하게 분산되어 더 균형 잡힌 데이터셋을 나타냅니다.

FineVision과 Cambrian은 높은 다양성 계층을 차지하며, Cauldron과 LLaVA보다 훨씬 더 큰 개념적 폭(effective rank)을 보여줍니다. 그러나 가장 중요한 통찰은 높은 다양성 계층에서 나타납니다. FineVision과 Cambrian이 모두 유사하게 높은 effective rank를 보이지만, FineVision은 훨씬 더 높은 participation ratio를 가지고 있습니다. 이는 FineVision의 개념적 범위가 넓을 뿐만 아니라 훨씬 더 균일하다는 것을 보여줍니다.

Experiments and Results

FineVision의 효과를 검증하기 위한 일련의 실험을 수행했습니다.

Experimental Setup

모델 및 학습: 모든 실험에서 nanoVLM 프레임워크를 사용하여 460M 파라미터 SmolVLM을 학습합니다. 아키텍처는 SmolLM2-360M-Instruct 텍스트 백본과 SigLIP2-Base-512 비전 인코더로 구성됩니다. 별도로 명시하지 않는 한, 유효 배치 크기 512로 20,000 스텝 동안 단일 단계 학습 프로토콜을 사용합니다(32 H100 GPU로 약 20시간).

베이스라인: 3개의 주요 오픈소스 데이터셋과 비교합니다: The Cauldron, LLaVA-OneVision, Cambrian-7M.

평가: lmms-eval 프레임워크를 사용하여 11개 벤치마크의 다양한 모음에서 모델을 평가합니다.

Main Results

기존 데이터셋과 비교: FineVision으로 학습된 모델은 다른 오픈소스 데이터셋으로 학습된 모델보다 상당히 우수한 성능을 보입니다. FineVision 학습 모델은 11개 벤치마크 모두에서 가장 높은 평균 성능을 달성합니다. 처음 몇천 스텝 동안은 뒤처지지만 - 베이스라인에 없는 새로운 작업이 포함되어 있기 때문으로 보입니다 - 약 1 에폭의 학습 후 모든 다른 모델을 능가하여 우수한 일반화를 보여줍니다.

학습이 끝날 때까지 FineVision은 The Cauldron 대비 평균 절대 점수 개선 12.7pp, Cambrian-7M 대비 5.1pp, LLaVA-OneVision 대비 14.3pp를 제공합니다.

테스트 데이터 오염의 영향: 동일한 파이프라인을 통해 모든 데이터셋을 처리하여 테스트 세트 누출을 조사했으며, 베이스라인 데이터셋에는 일반적인 평가 벤치마크에도 있는 이미지가 2.15-3.05% 포함되어 있음을 발견했습니다. FineVision의 오염률은 1.02%에 불과합니다.

모든 모델을 각각의 데이터셋의 오염 제거 버전으로 재학습했을 때, 베이스라인 모델의 성능은 2.7-3.7pp 하락한 반면, FineVision 모델의 성능은 1.6pp만 하락했습니다.

새로운 GUI 기능: FineVision은 상당한 양의 GUI/에이전트 데이터를 포함하며, 이는 VLM에 중요한 새로운 기능을 나타냅니다. 동일한 460M 모델(FV-0.5B)을 Screenspot-V2와 Screenspot-Pro에서 두 가지 크기의 아키텍처적으로 동등한 SmolVLM2(Smol-2B 및 Smol-0.5B)와 비교했습니다. 소형 오픈 모델에는 매우 어려운 벤치마크이지만, 파인튜닝 후 FineVision 학습 모델은 4배 큰 아키텍처적으로 동등한 모델과 동등한 결과를 달성합니다.

Related Work

대규모 멀티모달 데이터 생성 파이프라인: LLaVA-Instruct-150K는 COCO 이미지에 대해 GPT-4 생성 멀티모달 지시를 보여주었습니다. DenseFusion-1M은 객체 탐지기, OCR, 깊이 추정기를 멀티모달 모델과 통합하는 2단계 지각 융합 파이프라인을 사용합니다. ShareGPT4V는 GPT-4V를 사용한 시드 → 확장 레시피를 개발했습니다.

멀티모달 Instruction Tuning을 위한 메타 데이터셋: MultiInstruct는 62개의 다양한 작업에 걸쳐 약 510K의 완전 인간 주석 인스턴스로 이 분야를 개척했습니다. InstructBLIP는 템플릿 변환을 통해 약 12개의 기존 데이터셋을 집계하여 약 160만 인스턴스로 확장했습니다. 2024년에는 Vision-FLAN, Cambrian-10M, The Cauldron, LLaVA-OneVision 같은 야심찬 컬렉션이 등장했습니다.

GUI 및 체화된 비전 데이터셋: OS-Atlas는 230만 개 이상의 스크린샷과 1,300만 개의 GUI 요소가 있는 크로스 플랫폼 GUI 코퍼스를 도입했습니다. ShowUI는 GUI 자동화를 시퀀스 모델링으로 처리하는 vision-language-action 모델을 제시합니다.

Conclusion

대규모의 오픈되고 엄격하게 큐레이션된 VLM 학습 데이터셋인 FineVision을 소개했습니다. 200개 이상의 공개 소스를 표준화된 대화 스키마로 통합하는 반자동화 human-in-the-loop 파이프라인을 통해 캡션, VQA, 문서 이해, OCR, grounding, GUI 상호 작용에 걸친 고품질 지도를 제공합니다.

경험적으로 FineVision으로 학습된 모델은 광범위한 벤치마크 모음에서 기존 오픈 데이터셋으로 학습된 모델을 일관되게 능가하며, 테스트 세트 오염 제거 후에도 이득이 지속됩니다. 집계 점수를 넘어 FineVision은 통합 액션 공간을 통해 특히 GUI/에이전트 설정에 대한 기능을 확장하여 일반화에 타겟 다양성과 결합된 규모가 중요함을 시사합니다.

데이터셋, 변환 레시피, 중복 제거 도구 및 사전 계산된 임베딩을 릴리스하여 투명하고 반복 가능한 연구를 촉진합니다. 큐레이션이 누출과 노이즈 지도를 줄이지만 한계가 남아 있습니다: 잔여 중복이 지속될 수 있고, 긴 컨텍스트 및 다중 문서 추론은 여전히 어려우며, GUI 제어를 위한 커뮤니티 벤치마크는 표준 학습 스택에 통합되지 않았습니다.

FineVision을 기반으로 보고 커뮤니티가 비디오, 더 풍부한 다국어 범위, 더 긴 컨텍스트 추론, 더 강력한 인간 평가 프로토콜로 확장하여 오픈 및 독점 VLM 학습 데이터 간의 격차를 더욱 좁히기를 바랍니다.